隨著信息技術的飛速發展,大數據已成為推動現代企業發展的關鍵引擎。高效的數據處理和存儲支持服務,不僅能挖掘數據價值,還能提升決策精準度。本文將全面介紹如何玩轉大數據開發工具,從數據處理到存儲服務,提供完整的技術視角。

一、大數據開發工具概覽

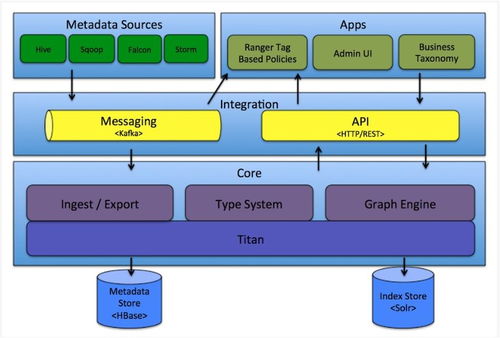

大數據開發工具是數據生態系統的核心,涵蓋數據采集、清洗、轉換和存儲的各個環節。例如,Apache Hadoop和Apache Spark在分布式計算領域表現卓越,支持大規模數據處理;而Apache Kafka則專注于實時數據流處理,確保高效的數據攝取。這些工具的組合使用,能構建靈活且可擴展的數據處理流水線。

二、數據處理:從原始數據到洞察力

數據處理是大數據流程中的關鍵步驟,涉及數據清洗、ETL(提取、轉換、加載)和數據分析。使用工具如Apache Spark,開發者可以快速執行復雜的數據轉換,并利用其機器學習庫進行預測建模。數據可視化工具如Tableau和Power BI,能將處理結果以直觀方式呈現,幫助用戶輕松獲取洞察。實際應用中,企業可通過Spark Streaming處理實時數據,實現即時反饋,提升運營效率。

三、數據存儲:構建可靠的數據倉庫

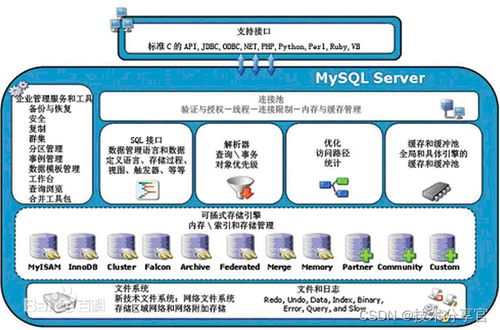

數據存儲是確保數據可用性和安全性的基礎。傳統關系型數據庫如MySQL適合結構化數據,而大數據場景下,NoSQL數據庫如MongoDB和Cassandra,以及分布式文件系統如HDFS,提供了高可擴展性和容錯能力。云服務如AWS S3和Google BigQuery則提供彈性的存儲解決方案,支持海量數據存取,并集成多種分析工具。通過合理選擇存儲方案,企業可以降低維護成本,同時確保數據長期可靠。

四、集成與優化:打造端到端數據服務

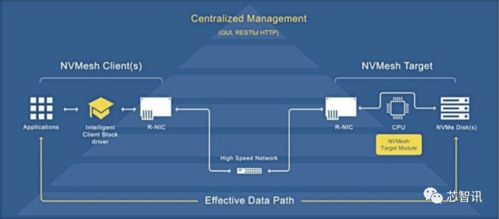

將數據處理與存儲工具集成,能夠構建端到端的數據支持服務。例如,使用Apache NiFi管理數據流,結合Hadoop和Spark進行批處理和實時分析,最后將結果存儲到云數據庫中。優化方面,關注性能調優和資源管理,如使用YARN進行集群調度,避免資源浪費。安全性和合規性也不可忽視,工具如Apache Ranger提供訪問控制,保護數據隱私。

五、實踐案例與未來趨勢

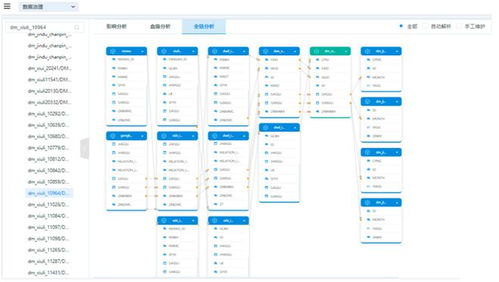

以電商行業為例,大數據工具可用于用戶行為分析,通過Spark處理日志數據,存儲于HBase,并利用可視化工具展示銷售趨勢。隨著AI和邊緣計算的興起,大數據工具將更智能,支持更復雜的實時分析和異構數據源集成。開發者應持續學習新技術,例如學習云原生工具如Kubernetes,以適應不斷演進的數據生態。

玩轉大數據開發工具,需要全面掌握數據處理和存儲的各個環節。通過合理選擇和集成工具,企業能夠釋放數據潛力,驅動業務增長。記住,實踐是關鍵——多動手實驗,結合具體場景,才能真正成為大數據領域的專家。